2025年11月29日(土) - 21:29 | カテゴリ:

Linux

筆者が管理する自鯖はVPSとKVMのハイブリッド構成になっており、

その中の一つにProxmoxを使ったZFSミラー構成のサーバがある。

稼働してから4年経つProxmox鯖だが、2週間ほど前からSSDがエラーを吐くようになっていた。

自鯖とは言えディスク領域が吹き飛ぶのは悲しいので、

更新用のSSDを追加購入してSSDの入れ替え作業をやってみた。

参考にしたWebサイトは以下の3サイト。

Proxmox公式で公開しているドキュメントだけでも十分だが、

ZFSのtrim設定もしたかったので違うサイトも見ていた。

実際に打ち込んだコマンドは次の通り。

proxmox-boot-toolを実行するか迷ったが一応実行しておいた。

また、SSDを入れ替えたのでtrimも改めて追加設定した。

# ls /dev/disk/by-id/ -ahl

# sgdisk /dev/sda -R /dev/sdb

# sgdisk -G /dev/sdb

# zpool replace -f rpool /dev/disk/by-id/ata-CT1000MX500SSD1_(略) ata-WD_Blue_SA510_2.5_1000GB_(略)

# pve-efiboot-tool init /dev/sdb2 –force

# proxmox-boot-tool format /dev/sda2

# proxmox-boot-tool format /dev/sdb2

# zpool set autotrim=on rpool

# zpool get autotrim rpool |

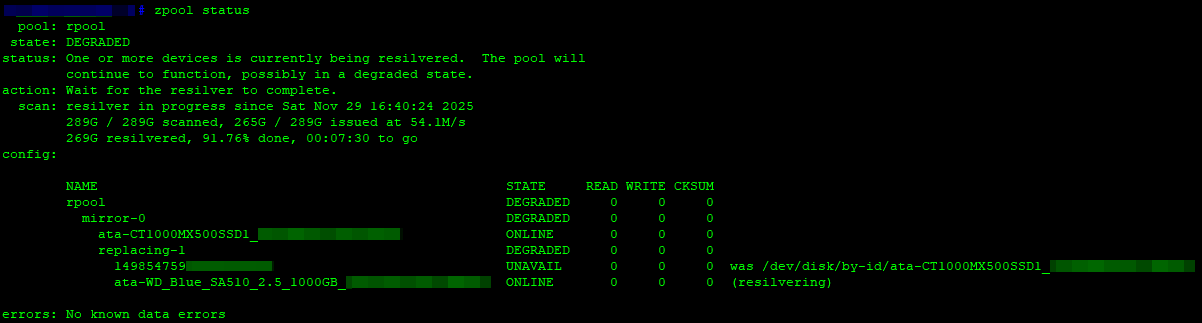

SSDを入れ替えてreplaceをしている時の実行画面がこちら。

300GBほどを同期するのに60~90分はかかっていたはず。

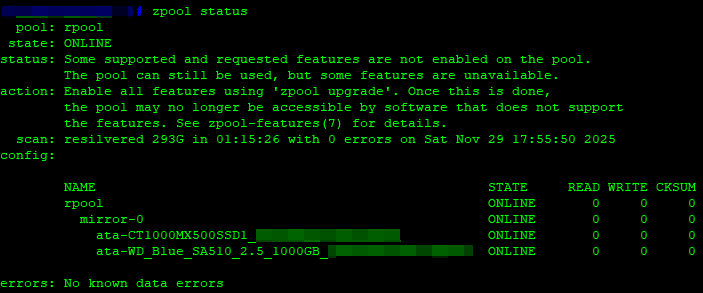

復旧後のステータス画面が以下のとおり、

SSDが別メーカーとなり気になるが近いうちに片方を変える事になりそうなので許容した。

仮想ゲストを稼働させつつディスク負荷をかけても問題は起きていないので、

挙動としても大丈夫そうだった。

………

想定外の出費となるのが非常に痛いものの、HDDとSSDは消耗品なので仕方ないと思う (´・ω・`)

落ちたらまずい主要サーバにはエンタープライズグレードのSSDを利用しているが、

全部をソレにするのは予算的に無理なので、コンシューマグレードの物を買い換えつつやり繰りしたいと思う。

« 続きを隠す

2025年09月20日(土) - 19:03 | カテゴリ:

Linux

以前からWordPressのプラグインでIndexNowの送付はしていたものの、

同期処理が都度発生するので改善したいと思っていた。

プラグインを乗り換えつつテストもしたが、しっくり来なかったため最終的に自力で作る事に。

という事で、Webmaster Toolsへ対応させつつ、sitemap.xmlの更新分のみIndexNowを送信するスクリプトを書いてみた。

サクッと作成したかったので、Qiitaで公開されていたsitemap.xmlを一覧化するスクリプトを使いつつ、

その情報をIndexNowとして送付できる様に外部スクリプトを作成して叩けるようにした。

………

作成したスクリプトは以下のリンクで公開したので、

Linux環境にダウンロードしてtar.gz形式のファイルを展開し、生成されたディレクトリを保存すれば動きます。

サンプル設定は、スクリプトを”/opt/indexnow”に保存するのを想定して書いてみました。

|

MD5: ec12f2402f988a784c6cd08bbb14eb98 |

サンプル設定をしているので、各々の環境に合わせて設定変更してから使ってください。

2サイト目以降も追加する場合は、SITEMAPとWEBSITEの変数添え字を”site2″のように変更すれば動きます。

| スクリプトの設定項目 |

設定内容 |

$SITEMAP{‘site1’} = ‘https://www.example.jp/site1/sitemap.xml’;

$WEBSITE{‘site1’} = ‘https://www.example.jp/site1/’; |

SITEMAP:sitemap.xmlを公開しているURL

WEBSITE:SITEMAPに対応する実WebサイトURL |

my $_PATH = “/opt/indexnow”;

my $_DATA = “${_PATH}/data”;

my $_FQDN = “www.example.jp”;

my $_KEY = “1234567890abcdefghijklmnopqrstuv”; |

$_PATH:スクリプトをインストールするディレクトリ

$_DATA:sitemap.xmlから生成したURLリストの格納先

$_FQDN:Webmaster Toolsに登録しているサイトドメイン

$_KEY:IndexNow登録用のAPI鍵 |

手動実行する場合はそのまま”submit.pl”を叩けば動きます。

スクリプトを定期実行するには、cronなどで”submit.pl”を実行してください。

………

実際に筆者もコレを1日2回実行して利用しており、

やりたかった事はこの時点で達成できたので筆者的は満足いく結果になった。

なお、IndexNowの送付が1日2回でリアルタイムにIndexNowへ通知したいケースもあると思いつつも、

頻度が高すぎると都度送信されてスパム判定されるリスクもあるため、筆者は1日2回の送信に落ち着いている状況。

IndexNowを使う効果の程はまだわからないが、Webmaster Tools管理画面の警告バナーが消えたのは良かった。

サクッと作ったので最適化の余地もあるが、

ガッチリ作ってもメンテナンスが大変なので今回はこの位にしようと思う。

« 続きを隠す

2025年09月13日(土) - 23:21 | カテゴリ:

Linux

常用してるPCにはWindowsを利用しており、OSもWindows10なのでEOLが迫っていた。

また、最近はライフスタイルも変わってエ○ゲもほぼしないのと、

重い処理も動画のエンコーディングしか無いので性能も十分ではあったのだが、

約6年前に組んだ自作PCなのでハードウェア的に不調になる事も増えてきていた。

前回も自作PCかつ普段の選択なら自作PCでパーツを集めて組むのだが、

前述の通り最近はPCをガッツリ使う機会も減ってきたのと、

そもそも自作PCだと予算オーバーだったため今回はBTOを買うことにした。

TSUKUMOやドスパラ等の大手を見つつ、ネット限定の聞いた事がないショップも比較してみたのだが、

筆者の用途と使い方に合っていて値段と性能のバランスが取れていたパソコン工房でBTOを頼むことに。

という事で、パソコン工房のLevelΘを買ってみた。

PCは茶色の段ボールに入っており、衝撃吸収に発泡スチロールを使っていた。

今回購入したのは以下のスペックのBTO PC。

注文当時はAMD製品が値引きされていたため、CPUとGPUの両方をAMDにする事で2万円値引きされた。

後から変更したパーツや追加した物もあるが、合計17万円に収まった。

| 種類 |

パーツ構成 |

| OS |

Windows 11 Pro |

| CPU |

AMD Ryzen7 7700 |

| Cooler |

PCCOOLER CPS RT400-BK |

| GPU |

ASRock Radeon RX 6600 |

| MBR |

ASRock A620M (※1) |

| MEM |

Crucial Pro DDR5-5600 UDIMM (※2) |

| SSD |

KINGSTON OM8TAP4512K1 [500GB] |

| HDD |

Seagate ST8000DM004 [8TB] |

| PWR |

hec HEC-650TB |

| CASE |

Thermaltake S100 (※1) |

※1:搭載はBTOオリジナルで恐らくメーカーOEM

※2:メモリを別途購入して交換

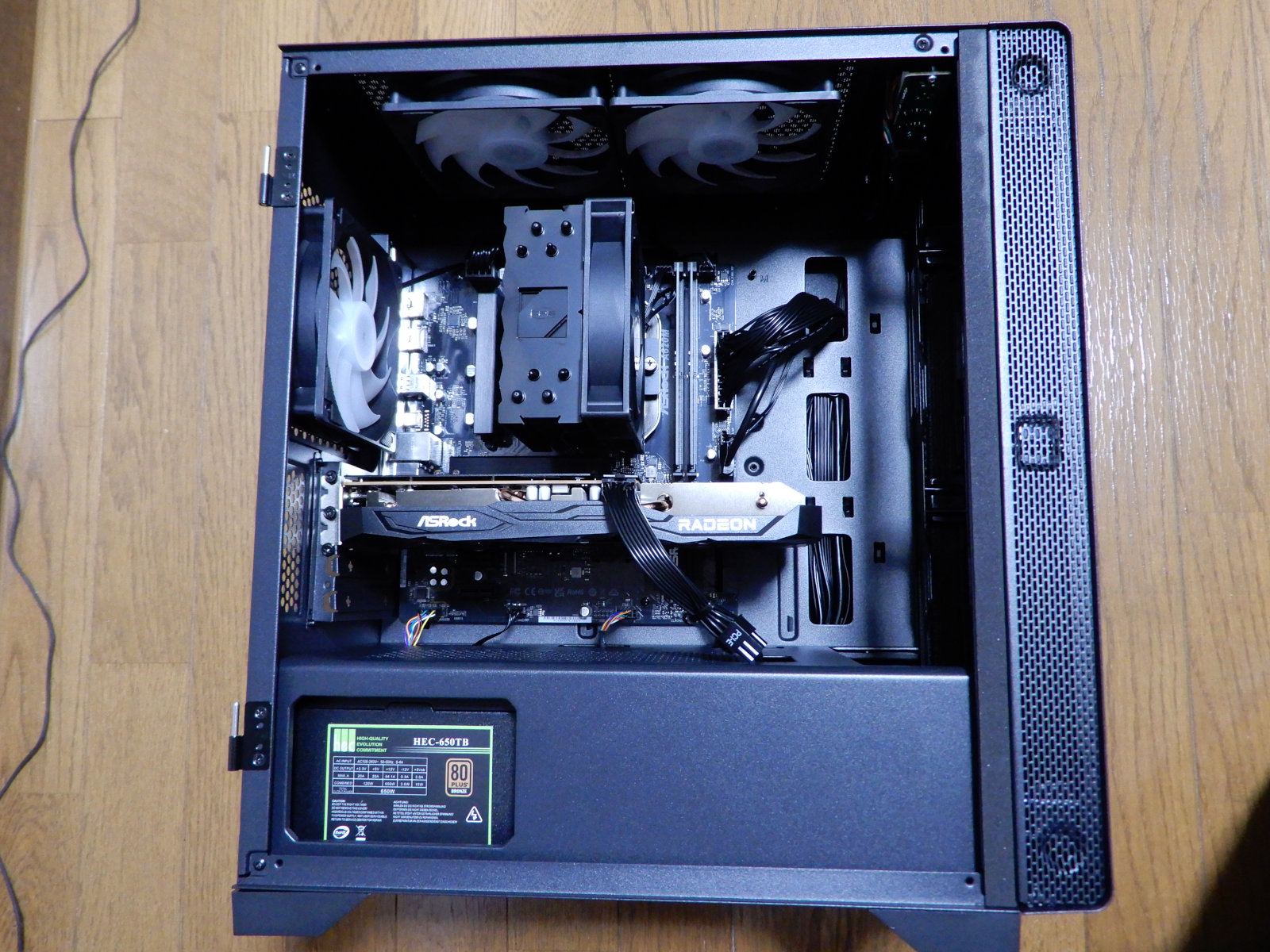

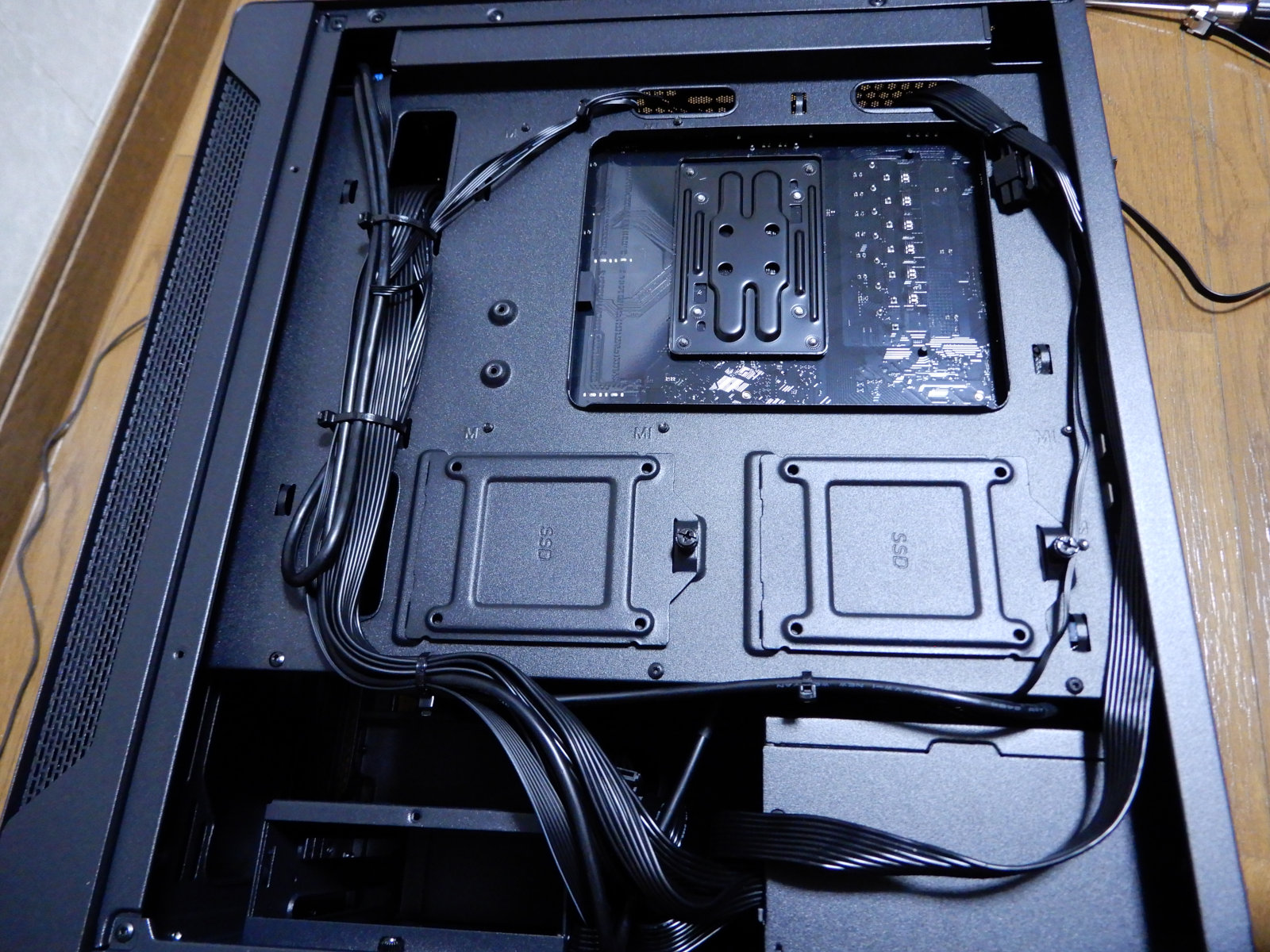

配線は綺麗にまとめられており、普段の自作PCでも参考になる配線具合だった。

パワレポ休刊により配線を見る機会も減っていたので細かい所まで見れて楽しかった。

ケースは剛性に難ありだが、値段を優先してBTOで妥協したのでコレで様子見する予定。

今まで使っていたPCケースは結構気に入っており残しておくので、

PCの剛性に問題やサイドパネルの強化ガラスに問題が出てきたら変えようと思う。

正直な所、電源は値段相応なのでコレに金をかける方針の筆者は若干物足りなかった。

今までの自作PCライフでも最初にダメになるのは大体電源なので、コレは載せ替えるかも。

バックパネルは上の通りで、マザボに搭載されているディスプレイポートはシールで封印されていた。

パーツによってはマザボからモニターへ出力できるが今回はグラボを積んでいるので、

接続先を間違えない様にするメーカー配慮と思われる。

バックパネルのUSBポートが5ポートと少ないのが困りものではあるが、

USB Type-Cが搭載されているので、コレを使ってハブを増設しても良いかもしれない。

または、マザボにUSBピンヘッダが余っていたので、コレを使ってポートを引き出すのも手かもしれない。

………

以前のPCから今回のBTO PCに入れ替えてから日は浅いが、今のところは正常稼働している。

当初は相性なのかケーブルが甘かったのかHDDが消失したりしていたが、

配線を調整したりHDD冷却用のファンを追加したらうまく安定する様になった。

次回のメインPC入れ替えがいつになるのか未知数だが、当面はこのまま利用予定。

メインPCから退役した物もパーツを入れ替えればサブPCとして通用するスペックなので、

状況によってはリビルドするかも。

なにはともあれ、以前のメインPCは約6年間安定して動き続けてくれて「お疲れ様」という気持ちと、

今後は新しく買ったBTO PCに「今後はよろしく」という思いで心機一転使っていこうと思う。

« 続きを隠す