コレは企業向けサービスな事もあり、月額8~250ドルで利用できるベーシックライセンスと、

機能を無制限に利用できるエンタープライズライセンスの二つがメインの内容となる。

だが、小規模環境や個人利用を目的とした機能制限ありのフリーライセンスと、

テスト用だけど15日限定で機能無制限かつ無料で使えるトライアルライセンスも用意されている。

お試し利用ならトライアルライセンスで十分試せるので、

実際に自宅サーバ関連で利用しているメールドメインのDMARCレポートを取り込んでみた。

………

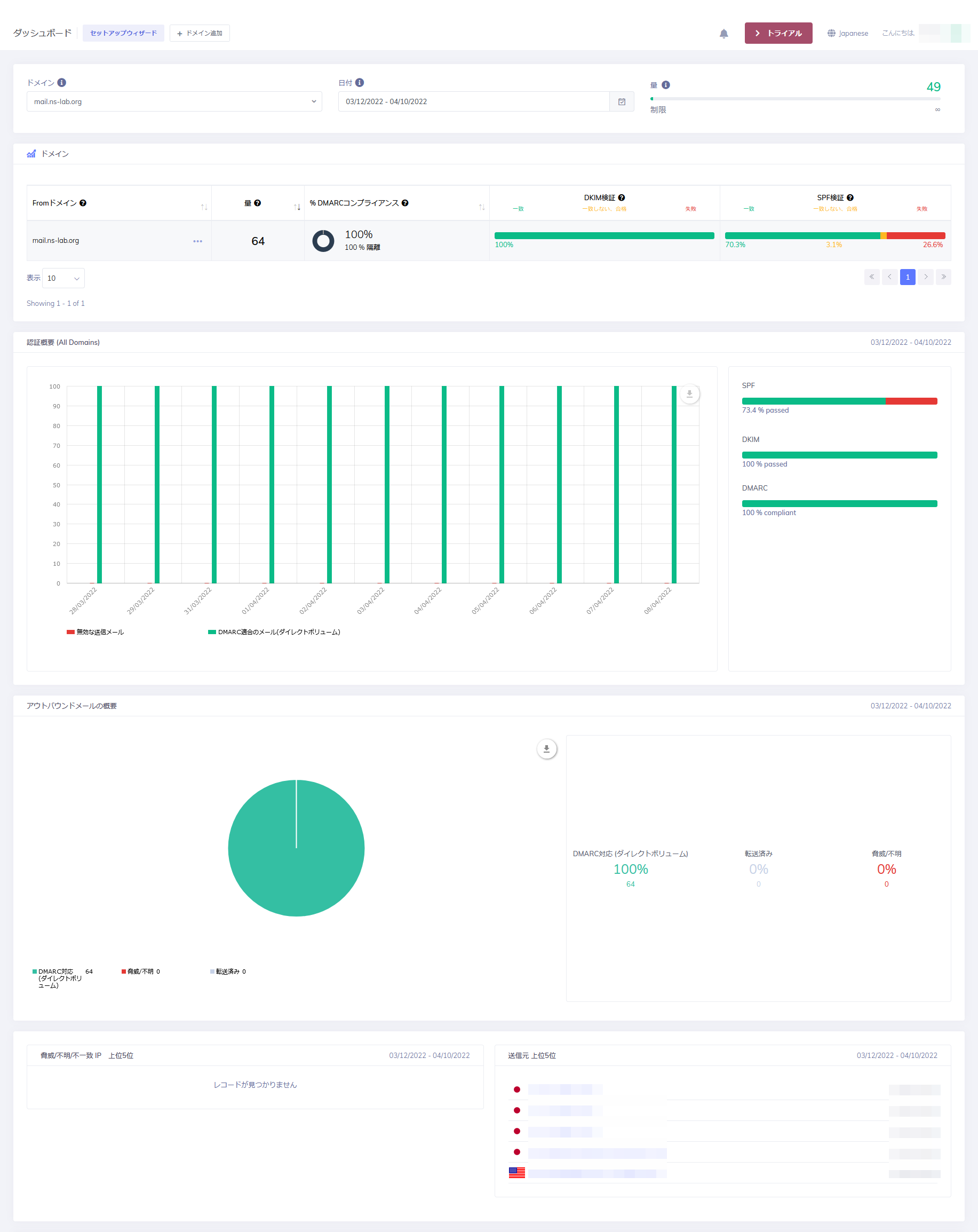

11日分のログを取り込み続けた結果とメインダッシュボードは次の通り。

PowerDMARCが海外サービスな事もあり日本語ローカライズが微妙な部分も多いが、

雰囲気で各項目の意味は分かる様になっている。

DMARCで需要な項目となる配送率を見たり、SPF・DKIM一致率も確認出来るようになっていた。

カーソルをグラフに持っていくと、項目の値がポップアップで表示出来る様になっており、

なんとも今風の画面構成と感じる作りだった。

今回は一個のドメインしか登録していないが、マルチドメインだと一画面で全部表示できる模様。

この辺りの作り込みはエンタープライズ環境を意識していると感じた。

………

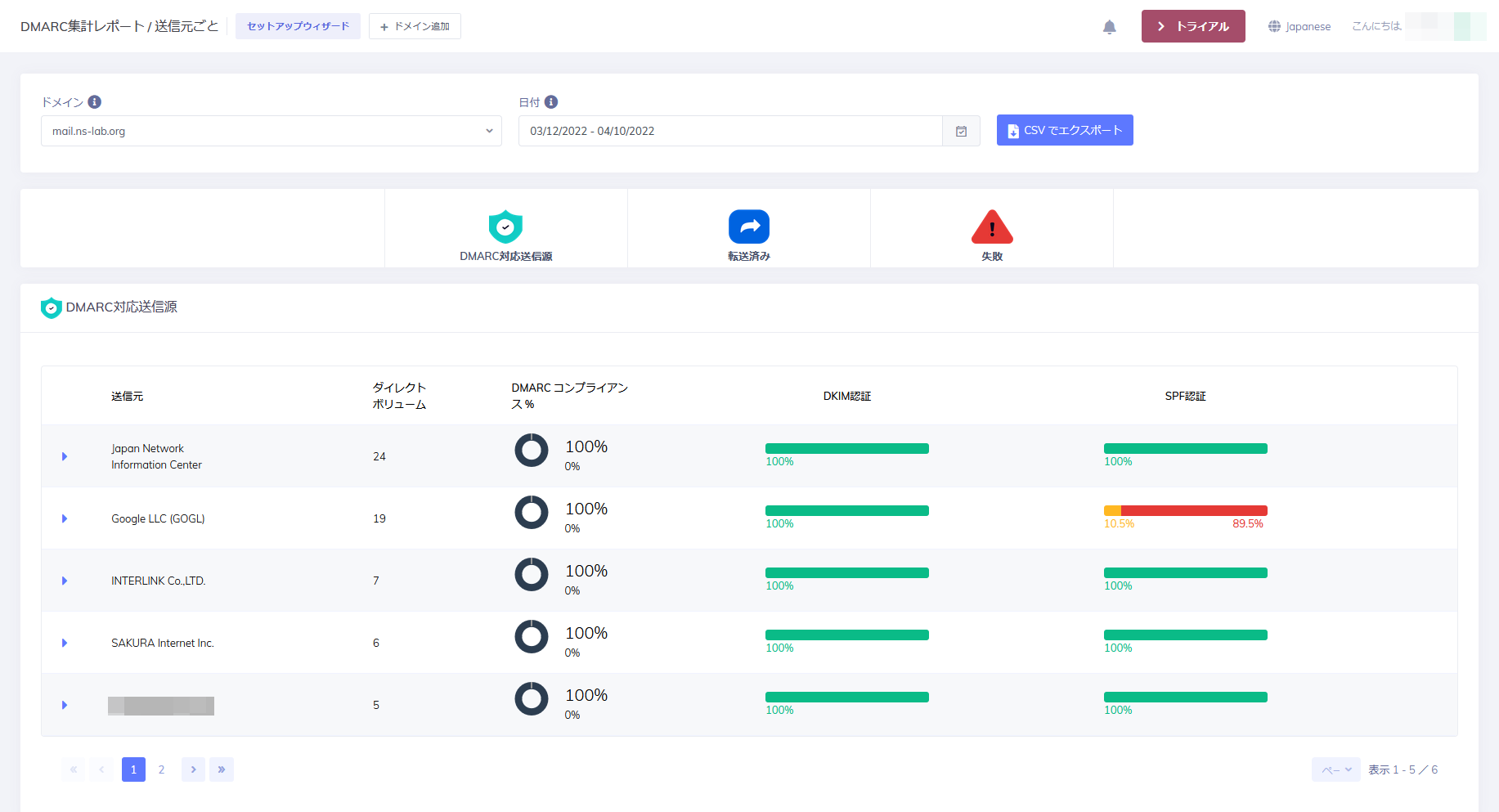

送信元サーバ毎のレポートも表示できるようになっており、

表示する項目を変更すればサーバやプロバイダ毎に集計した値を表示できる。

テストでSPF判定を失敗させたメールも正常に判定されていた。

JPNICから来るメーリングリストもDMARCに対応しているのだが、コレも正常に記録されていた。

他は自宅サーバ間で送受信した物だが、恐らくAS番号レベルでプロバイダが判定されていた。

………

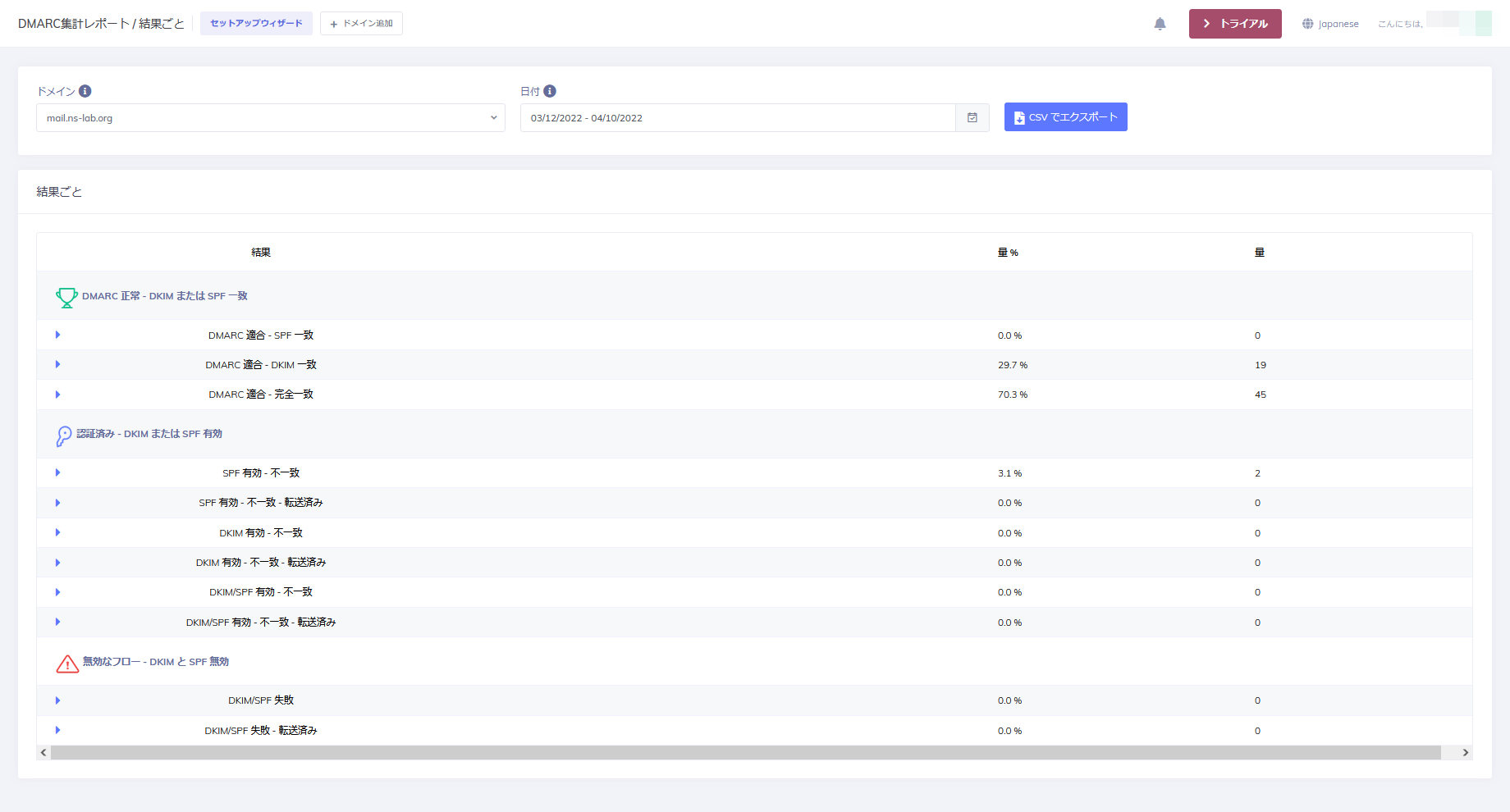

集計結果毎にレポートを表示する機能も備えておりドメイン毎の状況を一発で見れる。

レポートをCSVでエクスポートも出来るので、

エンタープライズ環境で良くあるステータス取り込みやスクリプト集計も出来そうだった。

………

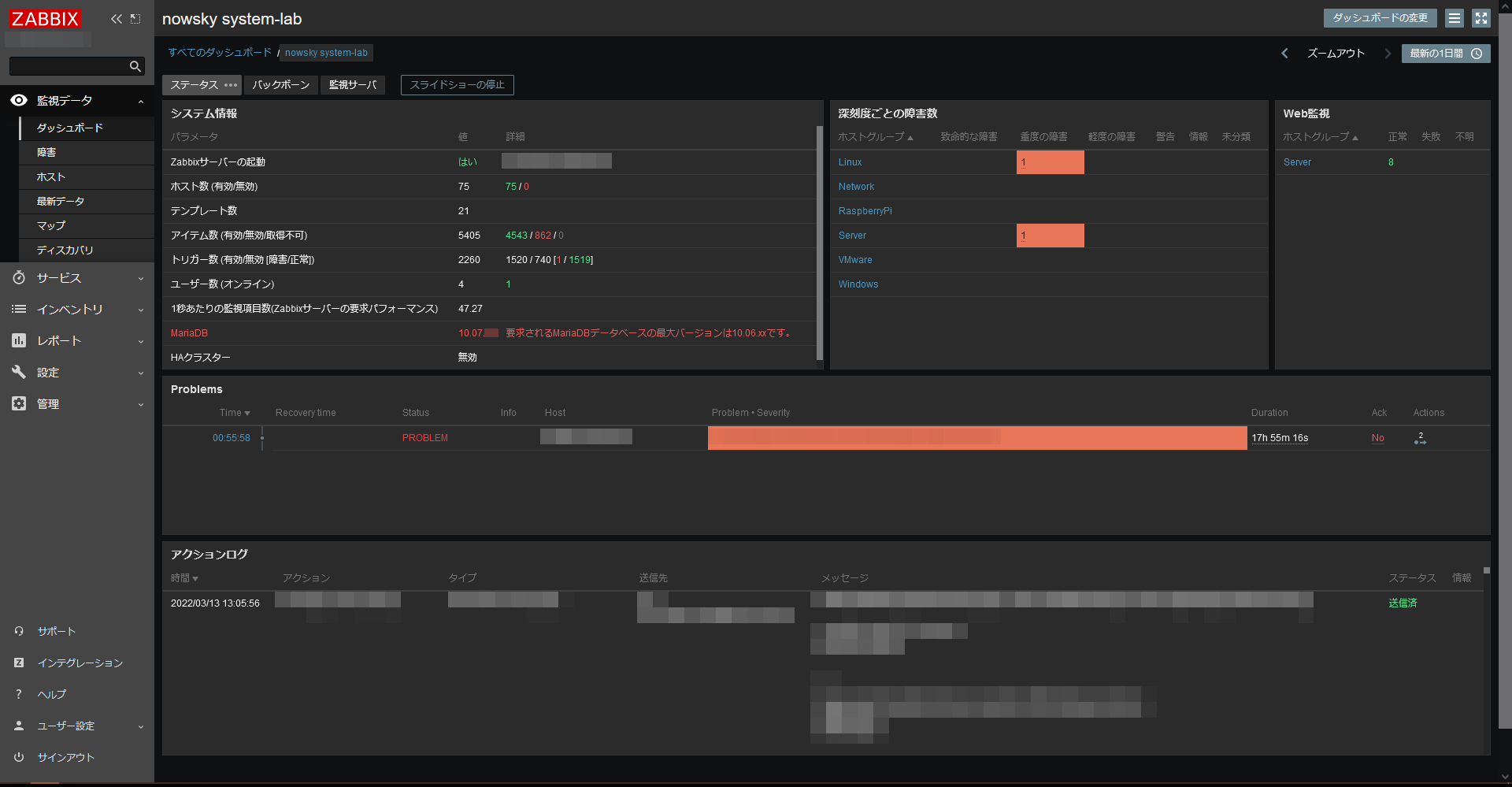

OSSでは無いので自鯖上で完結出来ないのが残念だが、

DMARCレポートの受信とWebフロントエンドの連携が必要になる筈なので、

アプリとして外出しするんは大変なんだろうと思う。

そういう意味でもSaaSで提供されているのは理にかなっていると感じた。

そもそも、個人でDMARCまでフルで有効化している人は本職がメール関係の人か、

余程の変人だと思うのでDMARCレポートツールを使う機会は殆ど無い筈。

それを差し置いてもツールとして完成度が高いので、

DMARCを有効化したメールドメインを持っている人なら、

お試しで使ってみると配送状況を可視化出来て面白いかもしれない。

« 続きを隠す