HPE製品はサポート契約しないとアップデート用のBIOSを入手出来ない点が問題だが、

中身はDebian/UbuntuのProxmoxならハードウェア問題も発生しにくいと判断して許容した。

むしろ、この問題こそProxmoxを選んだ理由の大部分を占める。

NICは計3ポート搭載されており、2個がデータ送受信用で1個がiLO専用ポートとなる。

ディスプレイはD-Subのみ搭載なのでサーバっぽいと言えばサーバらしいが、

最近のモニタでは搭載していない事もあるので要注意ポイントだった。

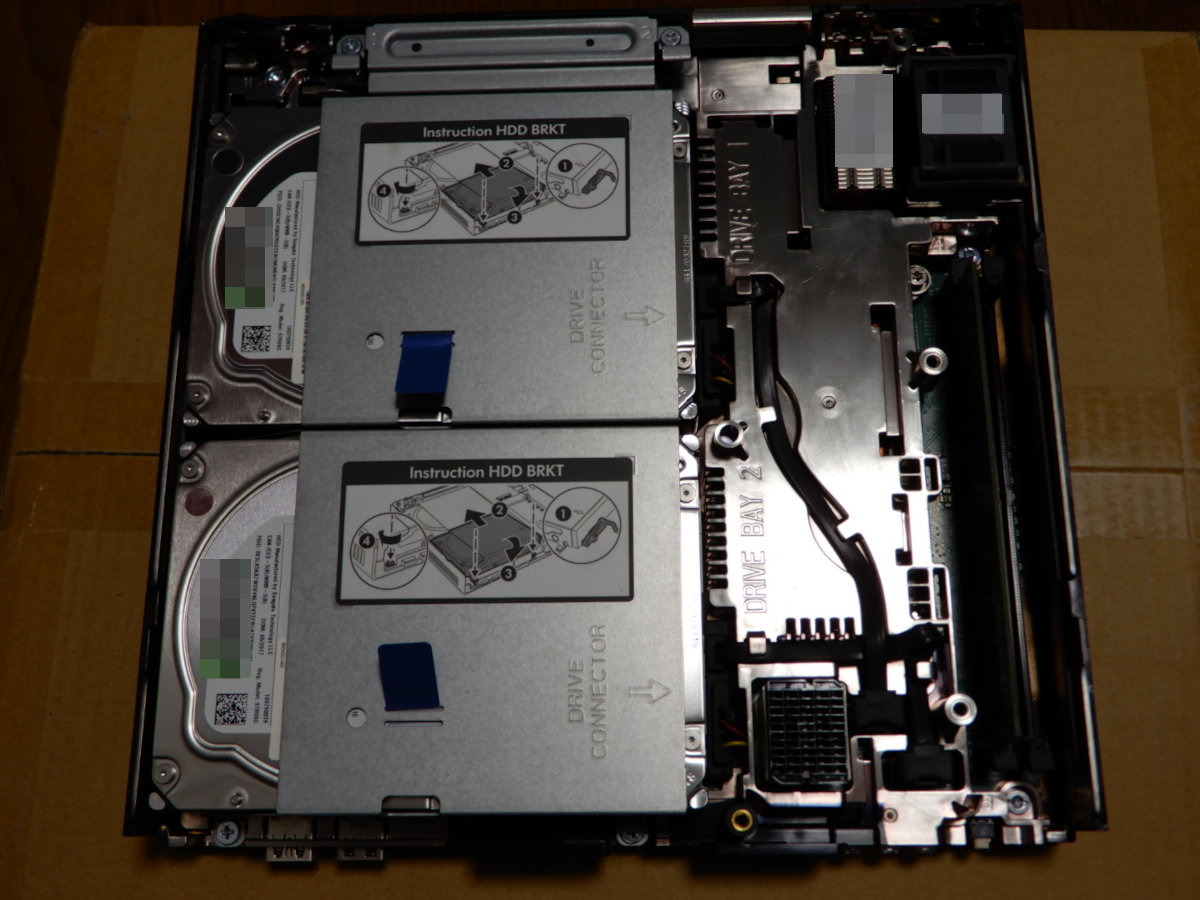

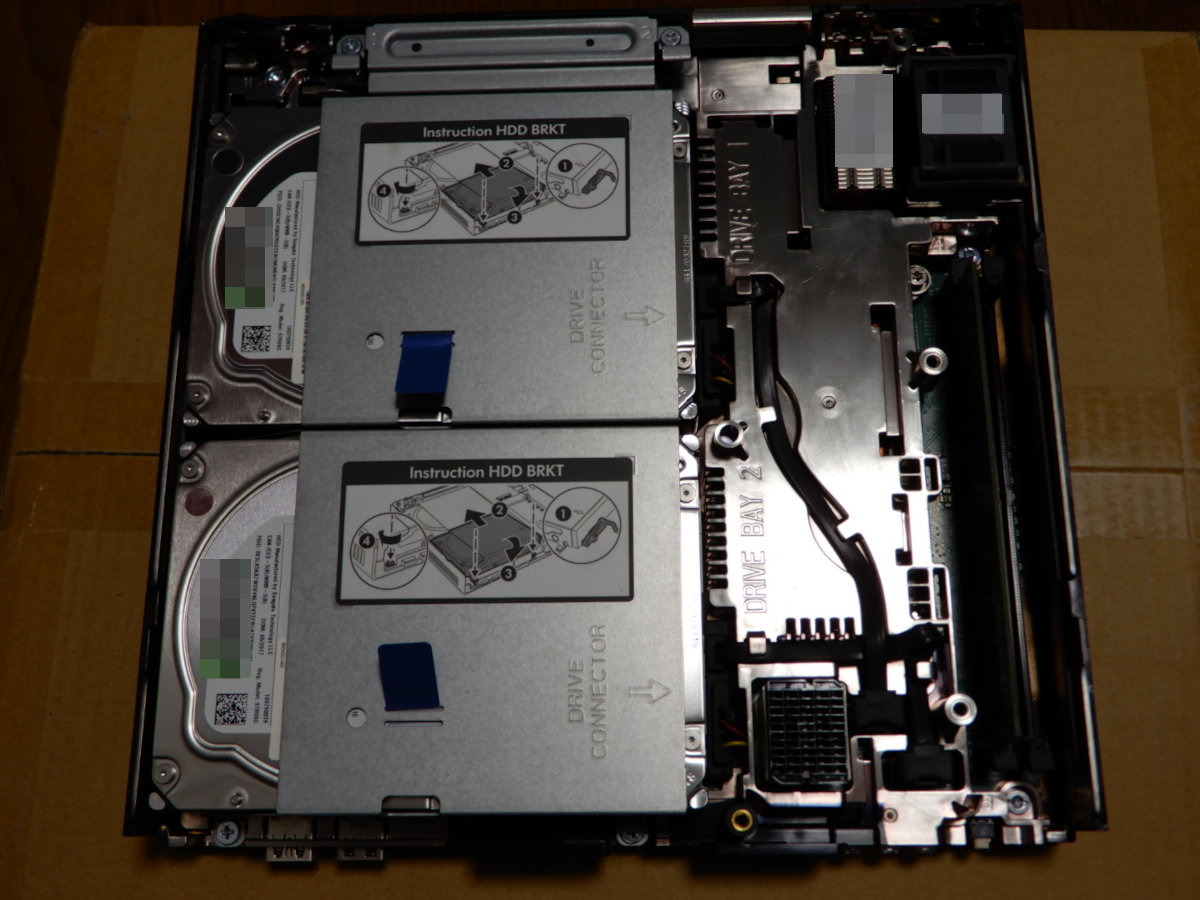

中身はギチギチに詰まっておりサーバらしく排気用の4cm角ファンを搭載していた。

拡張カードを搭載するスロットや、

ThinMicroシリーズのディスクエンクロージャーを増設する端子も搭載されている。

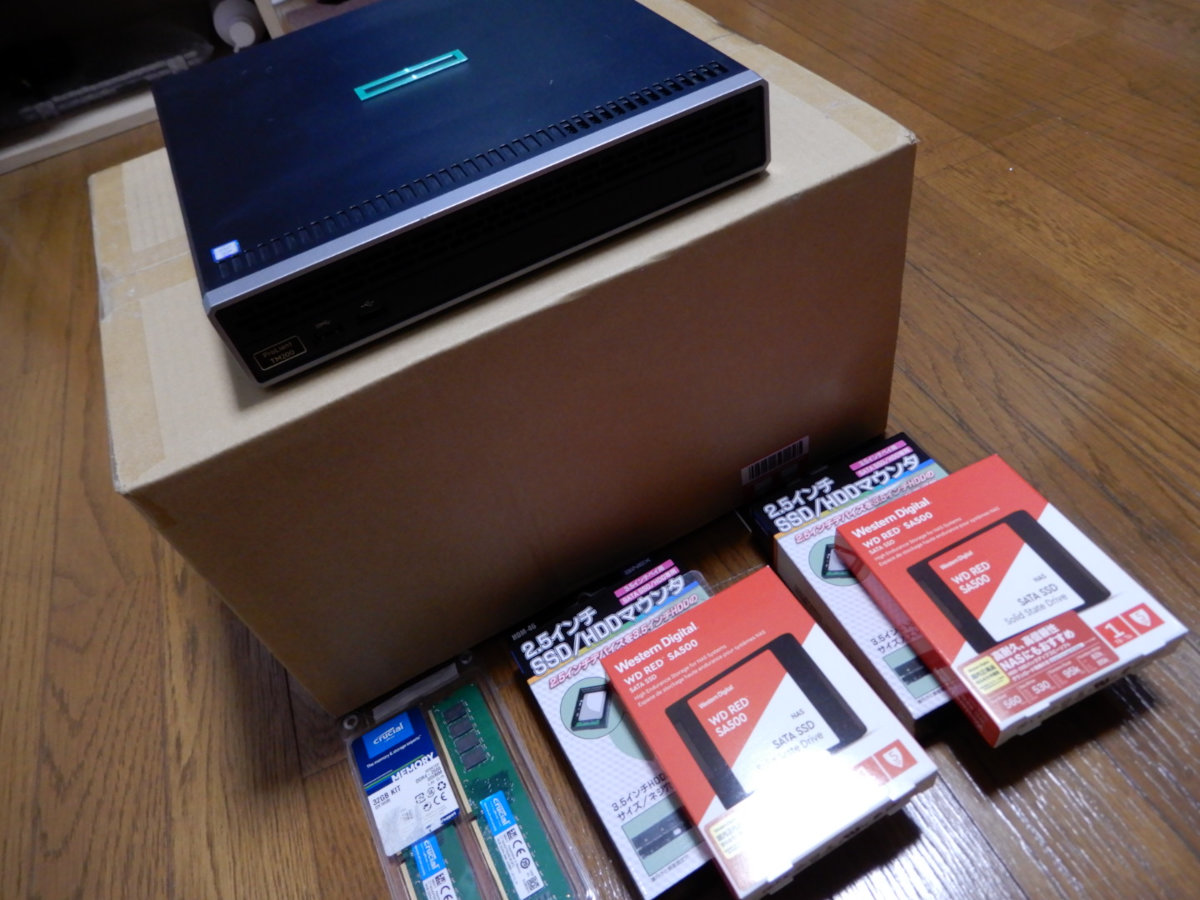

ディスクマウンタは3.5インチなので、2.5インチSSDを搭載する為にはマウンタが必要となるが、

今回は端子位置に互換性があるマウンタを2個購入する事でSSDを搭載した。

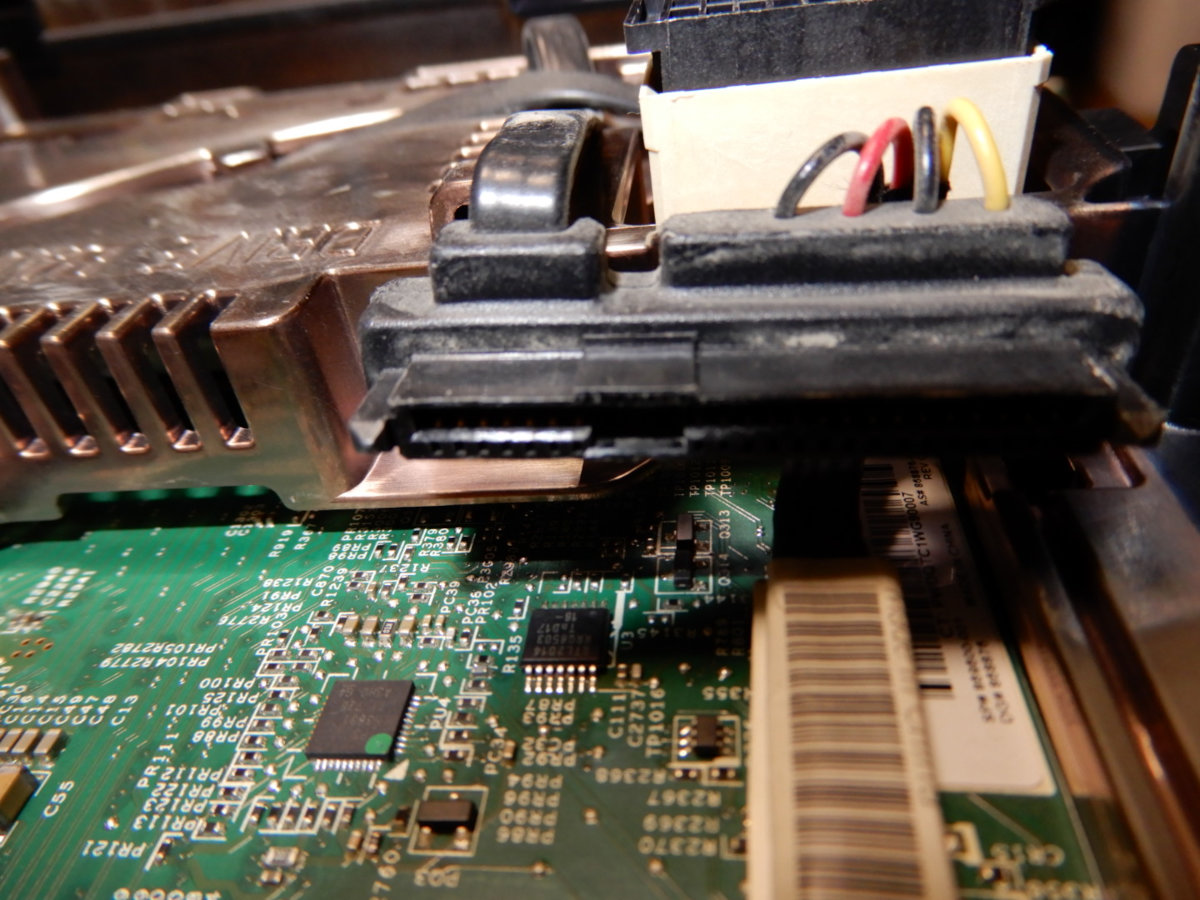

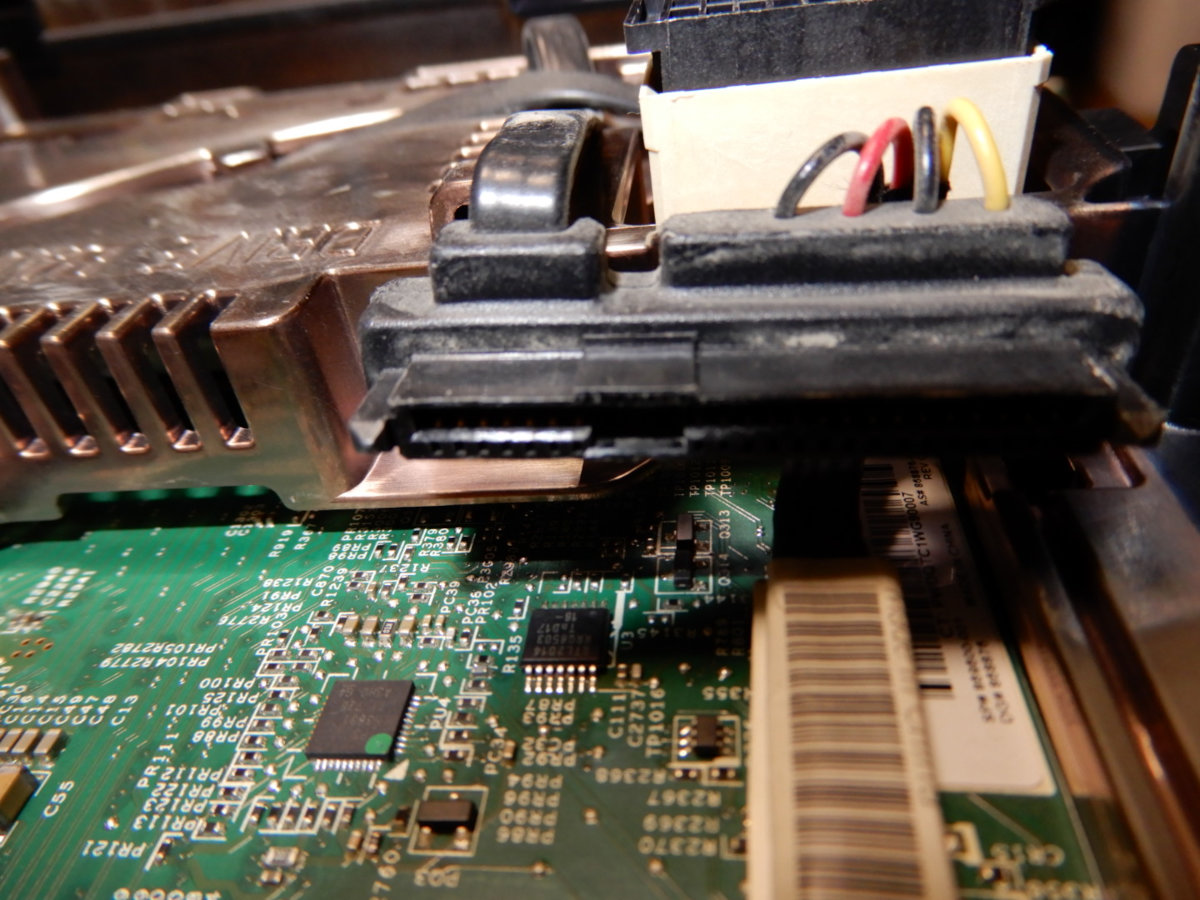

SATA電源ケーブルと信号ケーブルはコネクタが一体化されている。

信号ケーブルは普通のSATAケーブルなので断線しても入れ替え可能だが、

電源ケーブルはマザーボード側が独自規格となっており入れ替え出来なそうだった。

保守部材に困りそうなので、お金に余裕が出たらコールドスタンバイ用に1台追加しようと思う。

………

自作PCの様にSSD搭載とメモリ増設を済ませたらハードウェアの準備が完了。

早速Proxmoxをインストールしていた所、OS本体からインストールする場合は、

mdadmによるRAID-1構成を標準では組めずZFSミラーにする必要があった。

ZFSはメモリ消費が激しい印象が強く出来る限り利用したく無かったのだが、

経験上ファイルシステムを弄るとパフォーマンスや構成に影響が出やすいのと、

インストールと同時にZFS領域を作れば全てProxmoxから管理出来るメリットがあるので、

メリット・デメリットを比較した上でZFSミラー構成を今回は選択した。

Proxmoxのインストール画面をクリックしていたらディスク構成以外は難なく終了した。

普段からLinuxのインストールをしている人なら30分もあれば終わる内容だと思う。

初めてのLinuxがProxmoxになる人は早々いないと思うが、

そんな人にはハードルの高い箇所があるのでLinuxで慣れてから触った方が良いと思う。

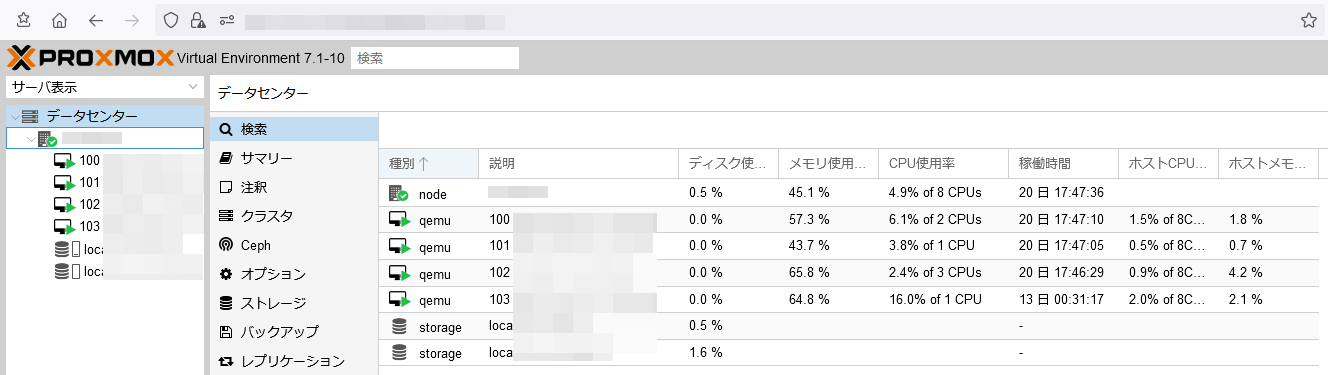

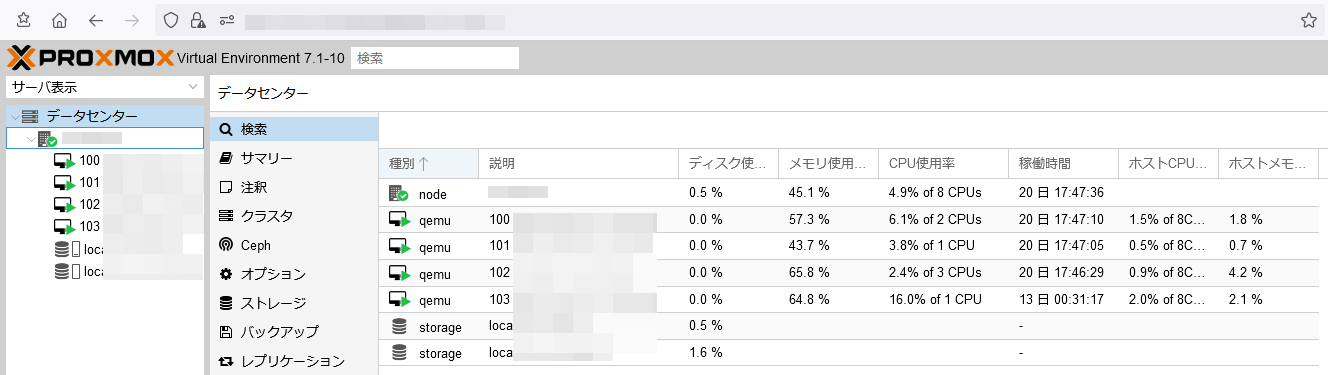

仮想サーバ1台と仮想ルータ3台を稼働させた状態がこちら。

ゲスト環境の負荷を一目で認識できるのは嬉しいポイントだったりする。

今回は利用していないがHCIの様に使う事出来るので、ディスクを管理する画面も備えている。

ZFSを利用する上で危惧していたメモリ使用率も今の所抑えられている。

“dedup=on”になっていない事を真っ先に確認したのも功を奏したと思う。

………

以前利用していたKVM管理ツールのKaresansuiや、今利用しているkimchiとも違う使い勝手だが、

画面構成が洗練されているからかドキュメントが無くてもゲストOSの構築まですんなり出来た。

流石にHAやHCIを組みだすとドキュメントを読まないと厳しいと思うが、

サクッと構築できるのは仮想サーバホスト構築の敷居を下げるメリットがあると感じた。

エンタープライズでオンプレミス仮想サーバホストを構築すると、

殆どのケースでVMware ESXiかOpenStackを使っておりProxmox事例は聞いた事が無いのが現状。

保守出来る所が少ないのも理由の一つだと思うが、

ホビー用途なら十分な利便性と性能を持っているので自宅サーバ勢の選択肢には上がると思う。

開発もまだまだ続く様なので実際に利用しつつ状況をウォッチし続けようと思う。

« 続きを隠す