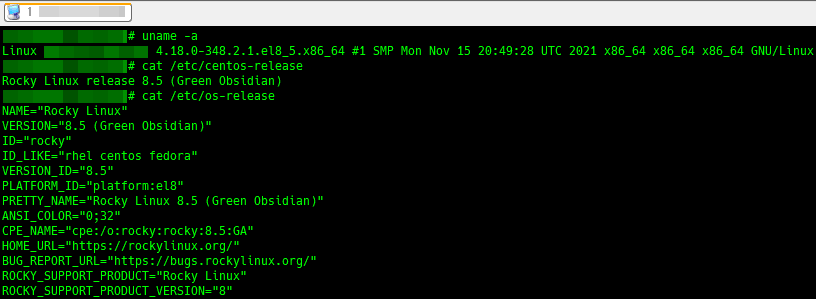

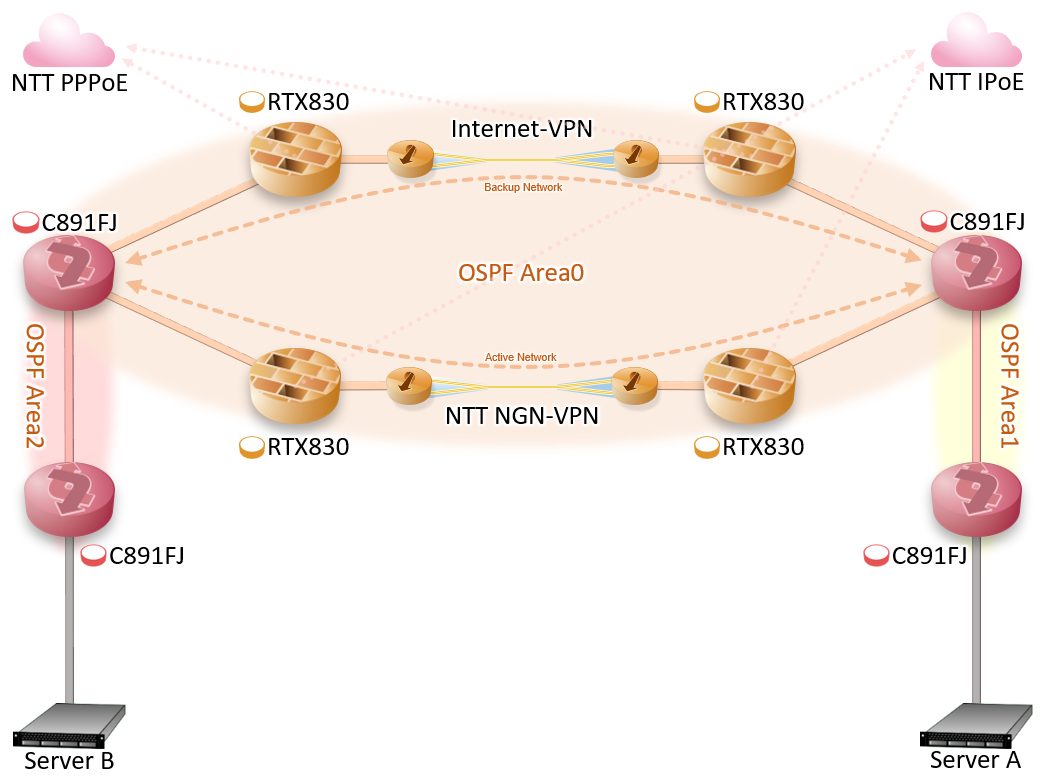

普通ならプロバイダ経由のインターネットVPNが主系・副系の候補になると思うが、

今回は主系をNGN-VPN・副系をInternet-VPNの冗長構成をとってみた。

プロバイダ費を抑えたと言っても検証目的の固定IPは必須なので、

検証回線経由で副系のInternet-VPNを張り、主系が落ちてもDNS等の通信は出来る様に構成。

主系・副系の経路が違う都合上ジッターのブレが大きくなりそうなので、

OSPFでコスト調整して通信経路を片寄し、ジッター影響が顕著にならない様にしてみた。

ジッターのブレが理由でインターネット経由のECMPはパケットが前後するリスクがあり没に。

NTT-NGNの話が長くなるので割愛するが、VPNを張る為にSoftEtherのDDNSサービスを利用した。

VPNのコンフィグはYAMAHAやSoftEtherが出してる次のドキュメントを参考にした。

RTX830をVPNルータに採用したのは、今までYAMAHAルータを使い続けていて慣れているのと、

インターネットに晒す部分はファームウェア更新で脆弱性潰しをやらないと危険な上、

ドキュメントが豊富なので不明点が出てきても解決しやすいからとなる。

VPNを1Gbpsまで出すには、RTX1210/1220やさらに上位機種を使うのがセオリーだが、

検証してみたらRTX830でも700Mbpsは軽く出せそうだったので、

既存環境で使っているRTX830に合わせる事にした。

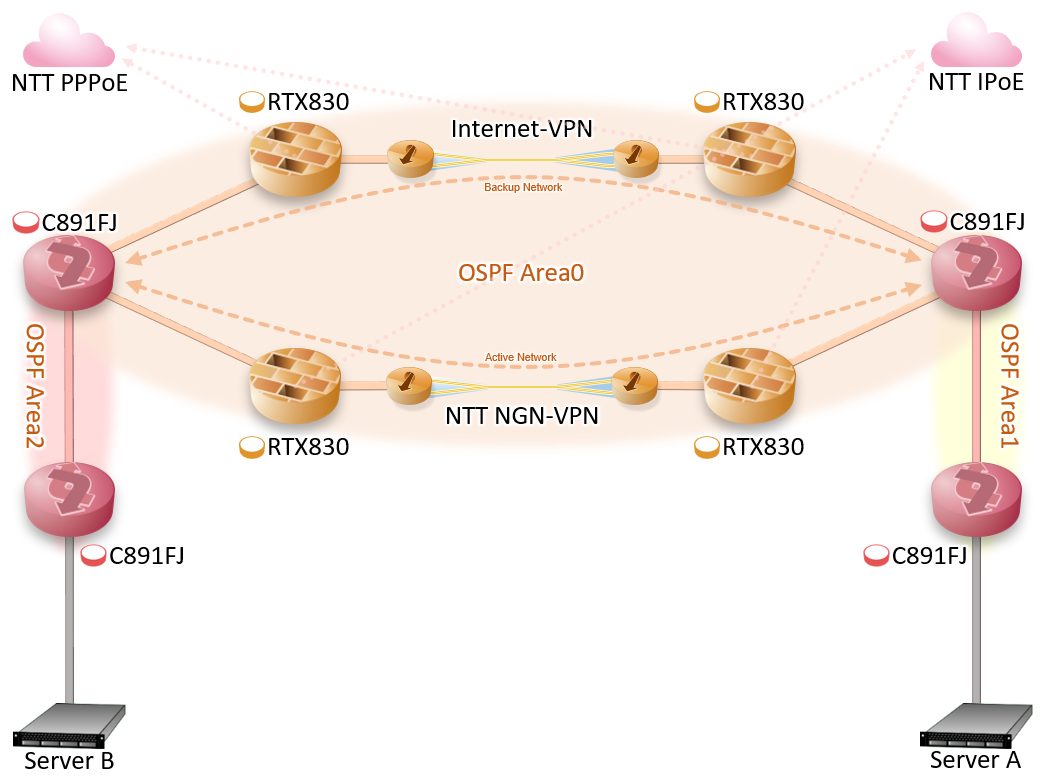

後で実際に通信してわかった事だが、NGN-VPNは回線利用率も影響して速度が変わるので、

実際は1Gbpsが絶対出ないのと、500Mbps程度出れば上々なのでRTX830でも問題無かった。

………

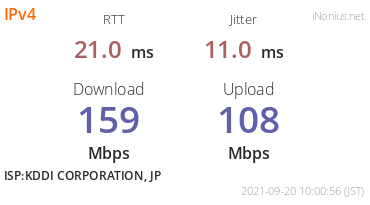

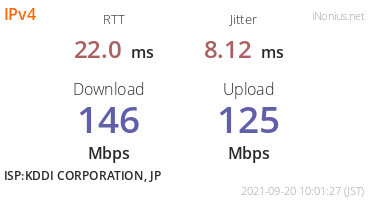

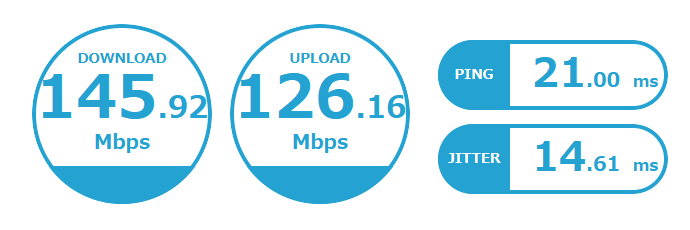

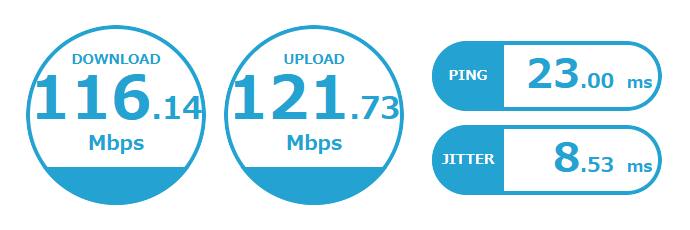

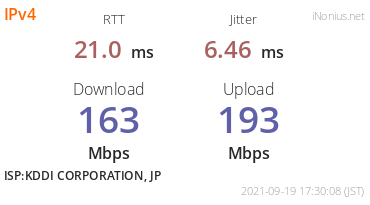

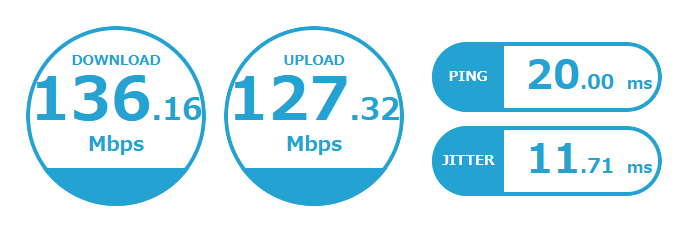

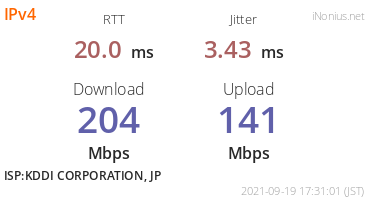

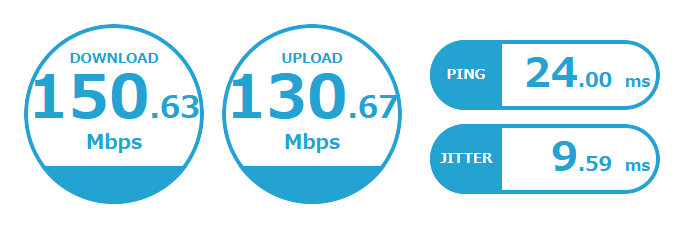

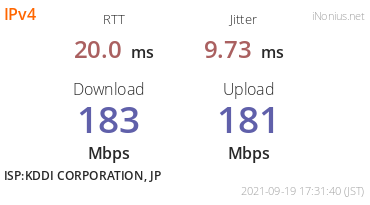

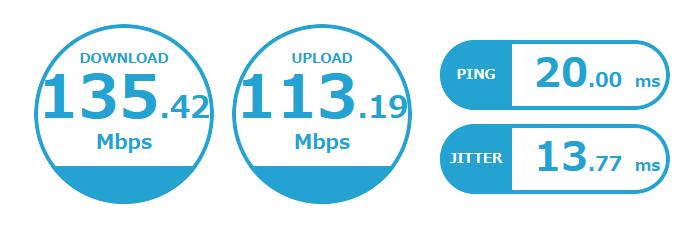

実際にVPN経由でスピードテストをしてみたのがこちら。

NGN収容局は2拠点とも違うが、同一県内なので県間伝送路は通らずNGN県内網で閉じている。

速度計測は土曜日に実施。スピード計測サイト毎に3回ずつ計測した。

計測日が土曜日という事もあり今回はそこまで速度が出なかった。

ちなみに、スピードテストをしている時はRTX830のCPU負荷が3~5%程度だった。

スペックシートでもVPNが1Gbps出ると書いてある上、

単純計算で負荷を10倍してもCPUに余裕があるので本当に出るかもしれない。

単発計測なので画像は無いが、早朝や夜中なら500Mbpsは出ていたので、

計測結果が150Mbps前後なのは、回線が混んでいて速度が出なかった物と思われる。

………

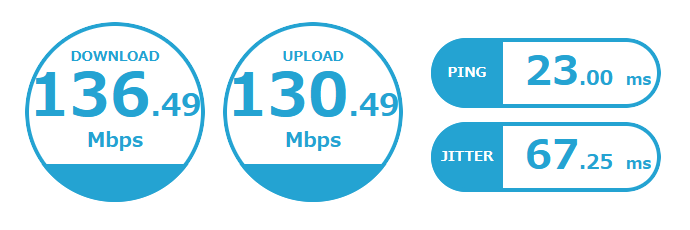

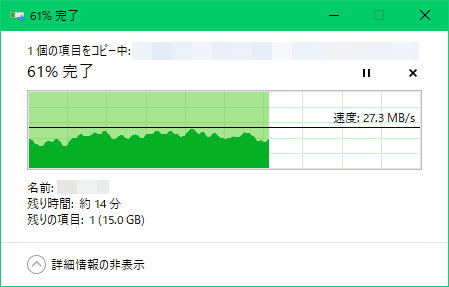

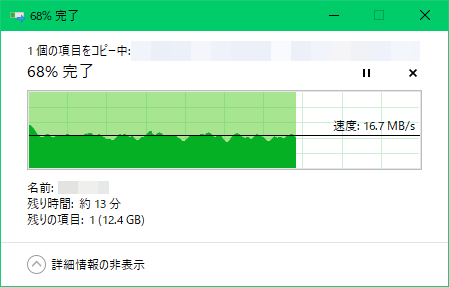

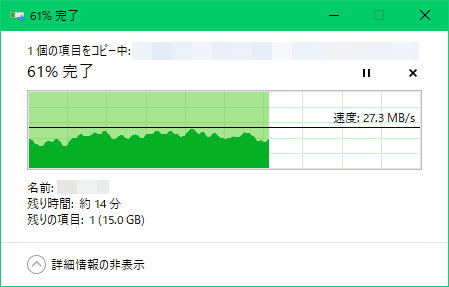

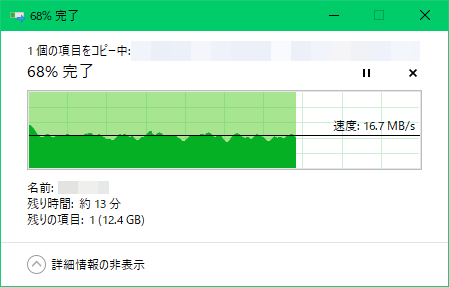

NGN-VPN経由で拠点間のCIFS通信をした結果がこちら。

スピードテストと同様の速度が出ていたので、計測結果としても精度は高そうだった。

20MByte/s(160Mbps)程度が出ておりVPN経由としては普通の速度だと思う。

サンプル転送したファイルは適当なデータを1ファイルに固めた物。

他にはCIFS通信に圧縮は使っていないので素の転送速度となる。

………

OSPFのkeepaliveをチューニングしてVPNとルーティングが安定する様にはしたが、

殆どサンプル通りに構築しただけで100Mbps以上の通信速度を出せるのは驚きだった。

流石にCIFS通信をガンガン流すのは近所迷惑なので控えているが、

普通の範疇となるWebブラウジングをしても遅延に気づかないレベルで利用する事が出来ている。

最初はNGN-VPNが本当に使い物になるのか疑問だったが、これなら当面は常用出来そうだった。

« 続きを隠す