2020年05月02日(土) - 22:55 | カテゴリ:

自作PC

半分は試験的に稼働していたHyper-Vサーバについても運用のコツが判ってきたのと、

別途進めている自鯖刷新の目的でもある、KVM/Hyper-Vのダブルハイパーバイザー構成を取る為、

Hyper-V用としてPCを新たに1台組んでみた。

前回のHyper-Vホスト構築時にもお世話になった、Shuttle製ベアボーンを採用。

2.5インチベイが1個しか無いが仮想サーバイメージはiSCSIに置いて運用するので、

データロストのリスクは許容する事にした。

今回購入したブツは下記の通り。C98が話題のアレで中止となってしまった為、

軍資金を一部投入してSSDのみエンタープライズ品にしてみた。

| CPU |

Intel Core i5 9400 |

22,000円 |

| MBO |

Shuttle DH310v2 |

26,000円 |

| MEM |

Team ELITE DDR4-2666 |

16,000円 |

| SSD |

Micron 5300 PRO 960G |

33,000円 |

| 合計 |

97,000円 |

最初はRyzenで組むか迷ったが、筐体がデカくなるのと今回は旨味が少ないので選択肢から除外。

Intelについても、Core i7にするとスペックを一気に上げられるので迷ったが、

Core i7だと値段も上がって予算オーバーするのでCore i5を採用。

補助記憶はSSDにしつつエンタープライズの “Micron 5300 PRO” を採用。

TBWがそれなりに高い上、SSDとしての耐久性もありそうなので採用した。

………

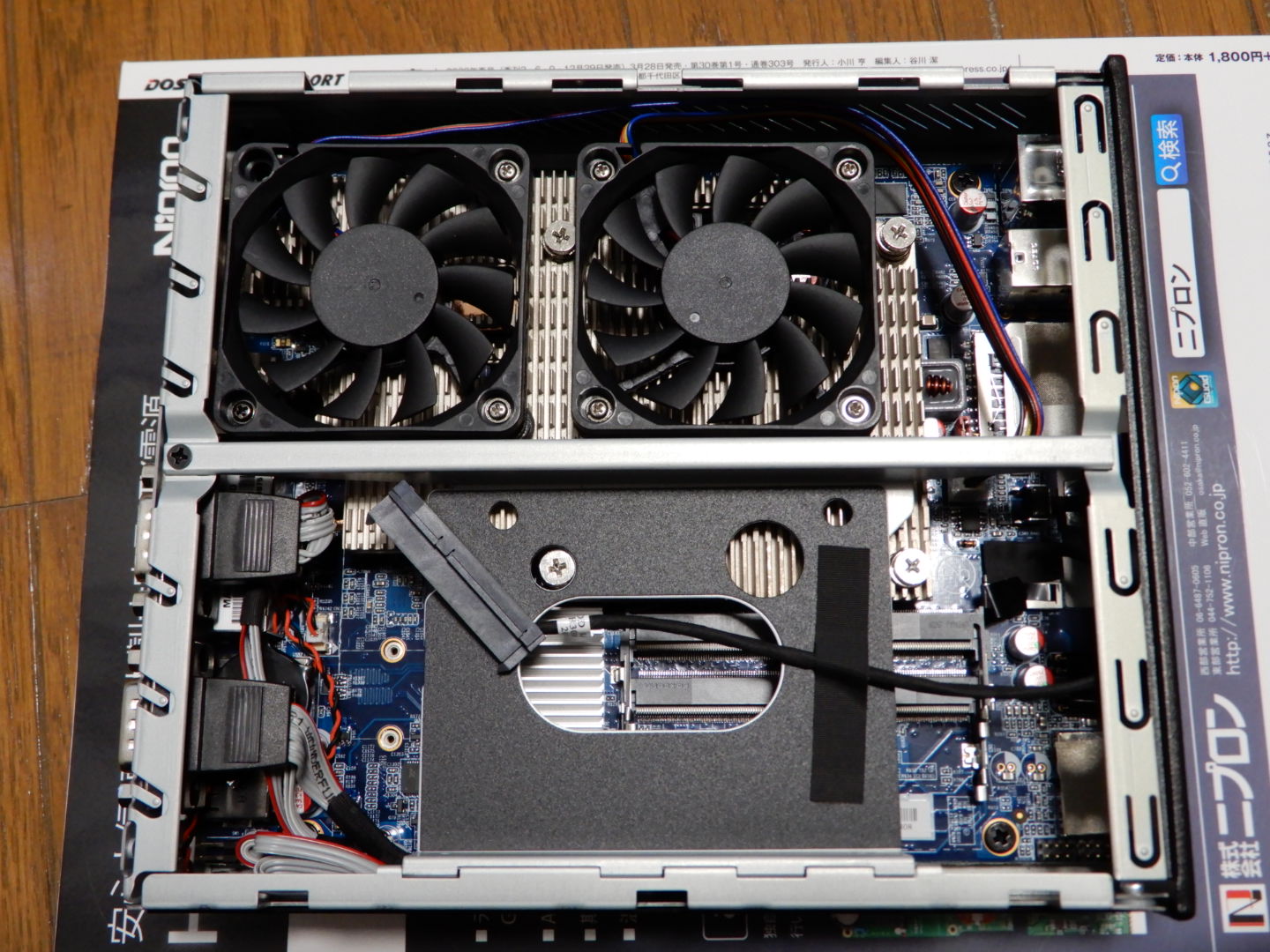

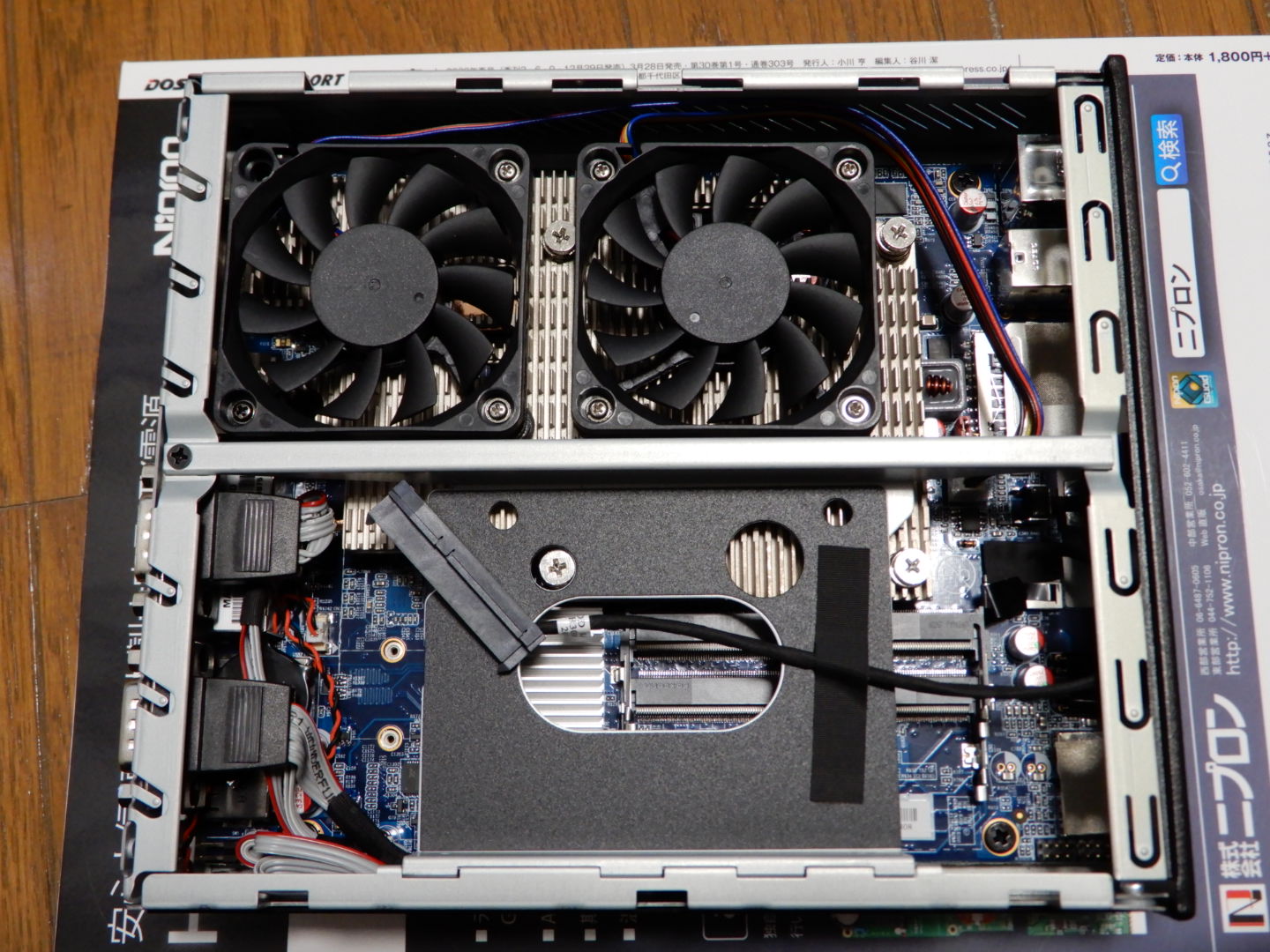

写真は上下逆になってしまったがご愛敬。

今回は2.5インチのみ使い、M.2は使っていないのでマウント後は右の様になった。

ファンとマウント位置の都合で、SSDがCPU排熱に耐えられるかが少し心配だが、

Hyper-Vホスト1号機もほぼ同構成で数年稼働しているので大丈夫な筈。

………

フロントベゼルはリニューアルされており、電源ボタンがフラットタイプになった。

また、USB3.0もフロントから引き出せる様になっている。

リアについては従来機通りNICを2機搭載してたり、シリアルも積んでいる。

変わった所としては右下の補助電源コネクタにプラ板の封印カバーが付いた。

………

WindowsServer用のドライバが無いので、INFファイルを書き換えてインストールする必要があったり、

マイクロコードを判別出来なくて、ドライバを手動インストールしてもエラーとなるのが課題だが、

RDP接続前提の運用形態なのと、Hyper-Vホストとして稼働させるには関係無さそうなので放置する事にした。

重要となるHyper-Vハイパーバイザー自体は正常稼働しており、

今回組んだサーバ上でゲスト3台をフルロードしても正常稼働し続けてくれている。

今回は時間の都合で記事が少なめだが、もう少ししたら、自鯖刷新の全体記事を書ける筈。

詳細はその時にレポートしようと思う。

« 続きを隠す

2020年04月18日(土) - 20:18 | カテゴリ:

PC

外出自粛な事もあり、自宅サーバ整備を着々と進めている筆者。

先週末に旧自鯖ホストの電源を落として、念の為1週間様子見をしていたのだが、

新自鯖も正常稼働しているので旧鯖を完全撤去した。

開いた場所には新自鯖を1台設置予定だが、まだSSDが届かないので構築はお預け。

来週・再来週にはSSDが届く筈なので届いたら組む予定。

それも見越し、LANケーブル配線と電源系統も見直しを実施。

最終的にLANケーブル10本撤去と、電源ケーブル2本撤去のシェイプアップが出来た。

最終的な設置状況は新自鯖が届いてから掲載予定。

これなら、当初の予定通り4月末までに完全移行が出来そう。

2020年04月11日(土) - 22:42 | カテゴリ:

PC

昨年から進めている自鯖更新も最終フェーズに入り、

遂に旧仮想サーバを停止する段階に来た。

サーバ間のデータ連係も移行済なので何も起きない筈なのだが、

監視サーバのアラートステータスと睨めっこしながら実機をシャットダウン。

無事に旧環境の仮想サーバ2台共に停止出来た。

これで、残る作業は2つ。

一個はHyperV仮想サーバを冗長化させる為に追加する事。

もう一個は旧サーバとLANケーブルの撤去作業。

既に、一部の旧サーバHDDは廃棄に向けてデータ消去作業を実施中。

コレばっかりは時間が掛るので様子見をしながら、

HyperVホストの追加作業も並行で進め、早めに最終構成にしておきたい。