システム紹介は他所様が書いてくれるので、筆者は実際に弄ってみた所感メインで書いてみようと思う。

冒頭にも書いた通り、第一印象は「Grafanaっぽいな」だった。

Zabbix単体でダッシュボードを作り込んだりGUIも担っている環境だと待ち望んだ機能だけど、

Zabbixはデータ収集に特化させてGrafanaなど外部ツールでフロントエンドを作る構成ではそこ迄かもしれない。

筆者の場合、監視サーバは冗長化しつつもZabbix単体のシングルソリューション構成にしているので、

単体でのダッシュボード表現に幅が広がったのは嬉しかった。

とは言っても、新グラフでグラデーションが作れなかったり細かい所でバグが見つかったりしたので、

今後の開発でブラッシュアップされるのでは無いかと思われる。

直せるなら自身で直したりコミュニティに報告をしたいが、

『プログラミングレベル = 1』の筆者スキルでは分からなかったので割愛。

実際に自宅鯖のダッシュボードをZabbix 7.0っぽく修正したのがこの画像。

タコメーターっぽいグラフを作れたり、ハニカムウィジェットが新規搭載されたのが嬉しかった。

閾値を上手く設定すれば色付きのメーター表示も出来るので、

デカい画面にダッシュボードを常時表示する様な用途にも耐えられそうだった。

ハニカムウィジェットの使い処は難しいが、筆者の環境ではping応答値を出す事にした。

従来型の表示をしても視認性が下がるのが課題だったので、

応答の遅い監視対象を一目で分かるようにしたり、視認性を重視するには良いと思う。

………

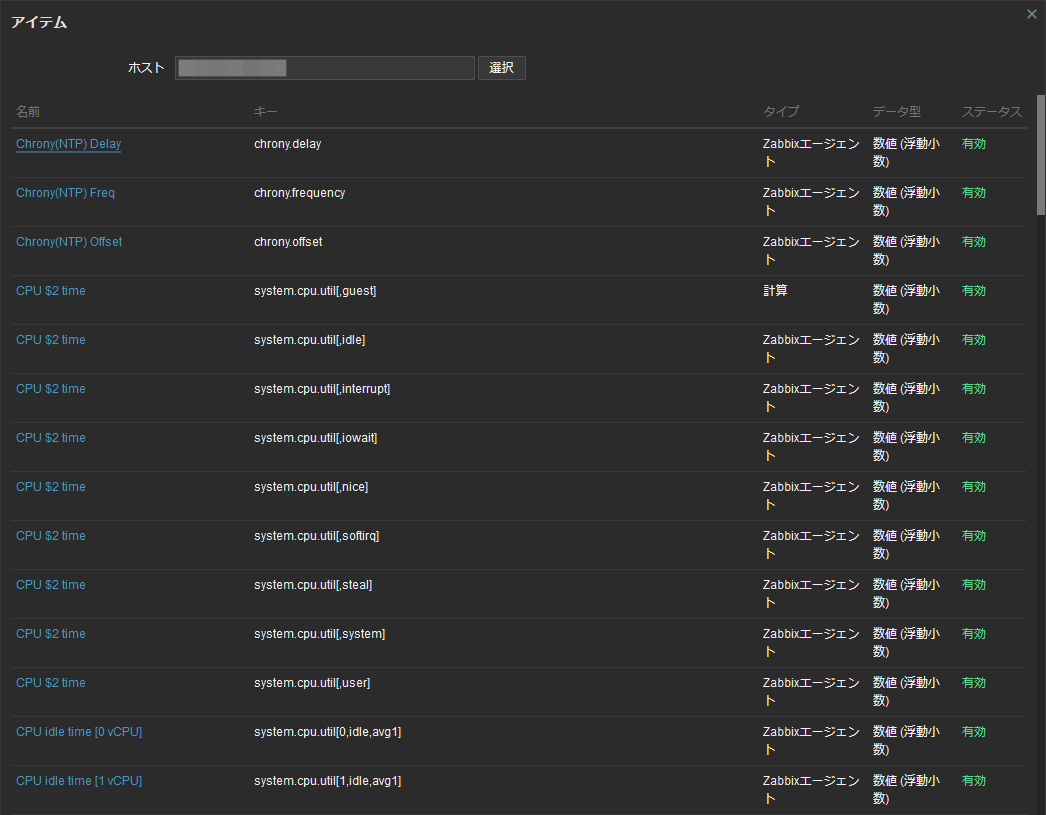

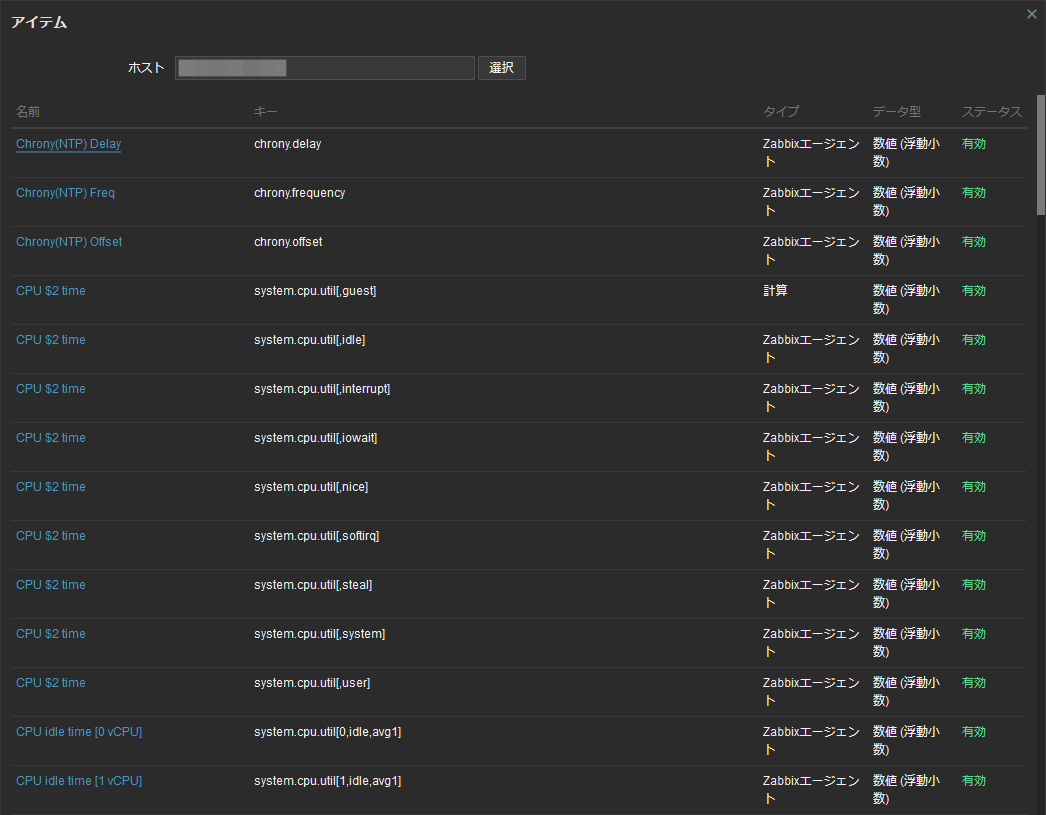

Zabbix 7.0のダッシュボードウィジェットで気になったのは、アイテム名をキーに表示しているっぽい所。

ウィジェット仕様かもしれないが、アイテム名を同じにしつつアイテムキーを別にする使い方をしていたら、

ウィジェットに設定したアイテムの一番上一つしか表示されなかった。

ZabbixのLLDと変数を組み合わせれば監視は動作するのだが、ダッシュボードは上手く動かなかった。

他にも同様の挙動をする箇所は以前からあったので、Zabbixの仕様なのかもしれない (´・ω・`)

アイテム名を変更すれば解決出来る筈だが、筆者の環境で変えるのは大変なので諦める事にした。

………

Zabbix 7.0にアップグレードしてから数日経過しているが、諦めた所以外は正常に動作してたりする。

新設したダッシュボードも正常動作しているので、Zabbix 7.0の完成度としては高めに感じた。

Zabbixは公式のバニラ版を使うのもアリだが、日本人ならMiracle Zabbix版を導入している環境も多い筈だが、

Miracle Zabbix 7.0は現時点で公開されていなかったので暫くお預けな人も多いかも。

Zabbix 7.0はLTSなので新しく監視システムを組むなら7.0の利用をおススメしたい。

特に、Zabbix ServerとZabbix Proxyの両方を冗長構成に出来るのがエンタープライズではメリットになる上、

今回紹介したダッシュボードの機能拡充は刺さる人が多いのではと感じた。

GUIの自由度を得る為に、Grafanaを使ったフロントエンドを作るのもアリだが純正が楽なのも事実。

古いZabbixを使い続けている人は、今回を機にZabbix 7.0 LTSへのアップグレードを考えて欲しいと感じた。

« 続きを隠す